人工智能|07 解锁GoogLeNet V3

第三个版本的Google Inception Net 论文题目为Rethinking the Inception Architecture for Computer Vision,从题目就可以看出这又是一篇研究性质的论文,没有全新的结构,但会带来一些新的技术思维,供读者们在自己的研究领域中借鉴。既然是谷歌出品肯定是影响非凡,所以自信的谷歌在本论文的开头部分就提出了设计深度卷积神经网络的一些准则,一切违反准则的设计都是假大空。

通用设计准则(General Design Principles)

本文中提出了四个设计准则,分别如下:

1、瓶颈网络不应过早出现,我们知道卷积网络总会有个下采样的过程,这就导致网络越往深处走,特征图的面积越小,形似一个瓶子,最终达到瓶口那样微小而细长的结构。如果你设计的卷积神经网络过早进入该阶段,那么表达能力就会大大下降。

2、高维度网络的表达能力更强,其实之前的文章也有介绍过,维度越高(深度越深),卷积神经网络学习到信息的抽象程度越高。一个良好的卷积网络,浅层是学习像素,深层则能够学习物体之间的构图关系。所以类似Dropout 这样压制不积极的激活度,力捧正宫娘娘神经元的技术做法,有助于网络加速收敛。

3、低维度的空间聚合(取前一层数据子集的过程,其实就是神经网络单层汇聚的过程)不会丢失很多信息。虽然整个卷积神经网络就像一个筛子,不断的筛走AI 认为无用的信息,但是在一开始的时候,相邻神经元学习到信息的冗余度非常高,所以如果你想加速你的神经网络,最好在浅层的聚合之前先降维。

4、平衡深度与宽度,这是一条总结性的忠告,我们如何让自己设计的卷积神经网络不胖不瘦呢?答案就是让其忠于数据,没有万金油网络,这是AI时代带来的最大变化,未来任何系统对任何人都是自然定制的。

因子卷积(Factorizing Convolutions)

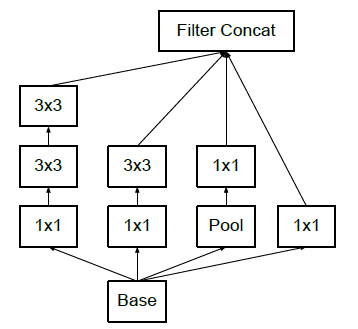

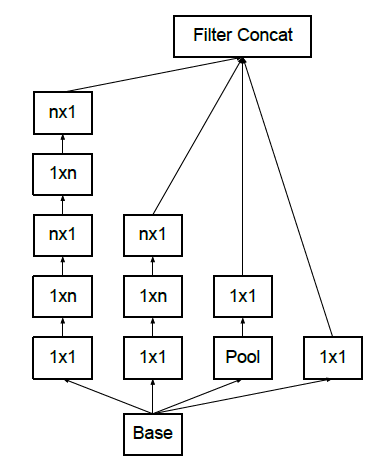

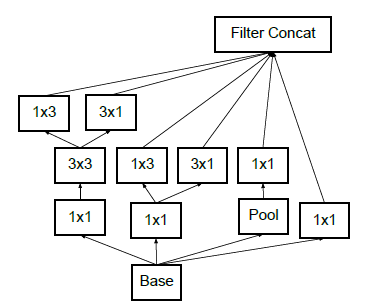

这一段描述比较简单,依然是意图使用较小的多个卷积层来代替单个大的卷积层。例如使用两个串联3x3来代替一个5x5,以及使用3x1与1x3来代替一个3x3等等。谷歌在这里玩的比较高兴,于是就制作了以下三个新的Inception层结构:

这三个新的结构,在论文中分别被称为Figure5、Figure6 与 Figure7。于是谷歌修正了GoogLeNet v1的模型,并产生了这一次的模型。有趣的是,论文中把这种模型描述为Inception v2,可能是作者觉得之前那个BN层并不算产生了新模型吧,模型描述如下图:

高效减肥(Efficient Grid Size Reduction)

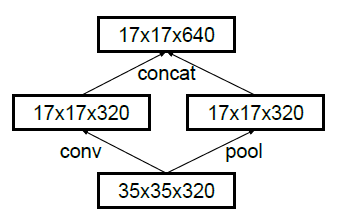

这里作者对比了减肥之前先降维,或者减肥后再降维两种方法,前者速度快但违反了通用设计准则一,即增加了瓶颈,而后者需要耗费三倍的计算量,似乎看起来都不太好。

所以作者干脆给网络来个岔路,一半进卷积层去减肥,一半做降维,之后再聚合,一方面避免瓶颈,另一方面减少计算量,双赢。

这篇研究性的文章就介绍到这里了,GoogLeNet也就介绍到这里了,接下来就会来到微软研究院的地界,下一篇我们一起来看看返璞归真的ResNet。

原文下载链接:https://arxiv.org/abs/1512.00567