人工智能|08 Resnet V1

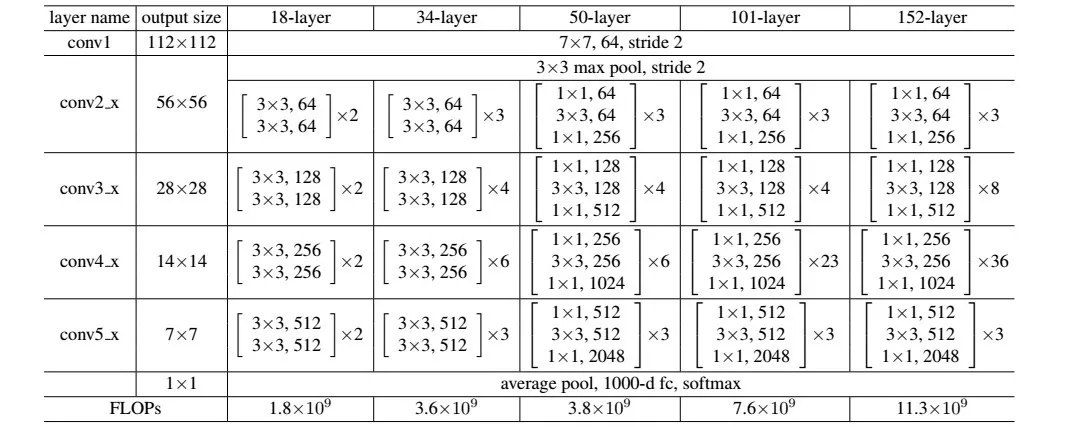

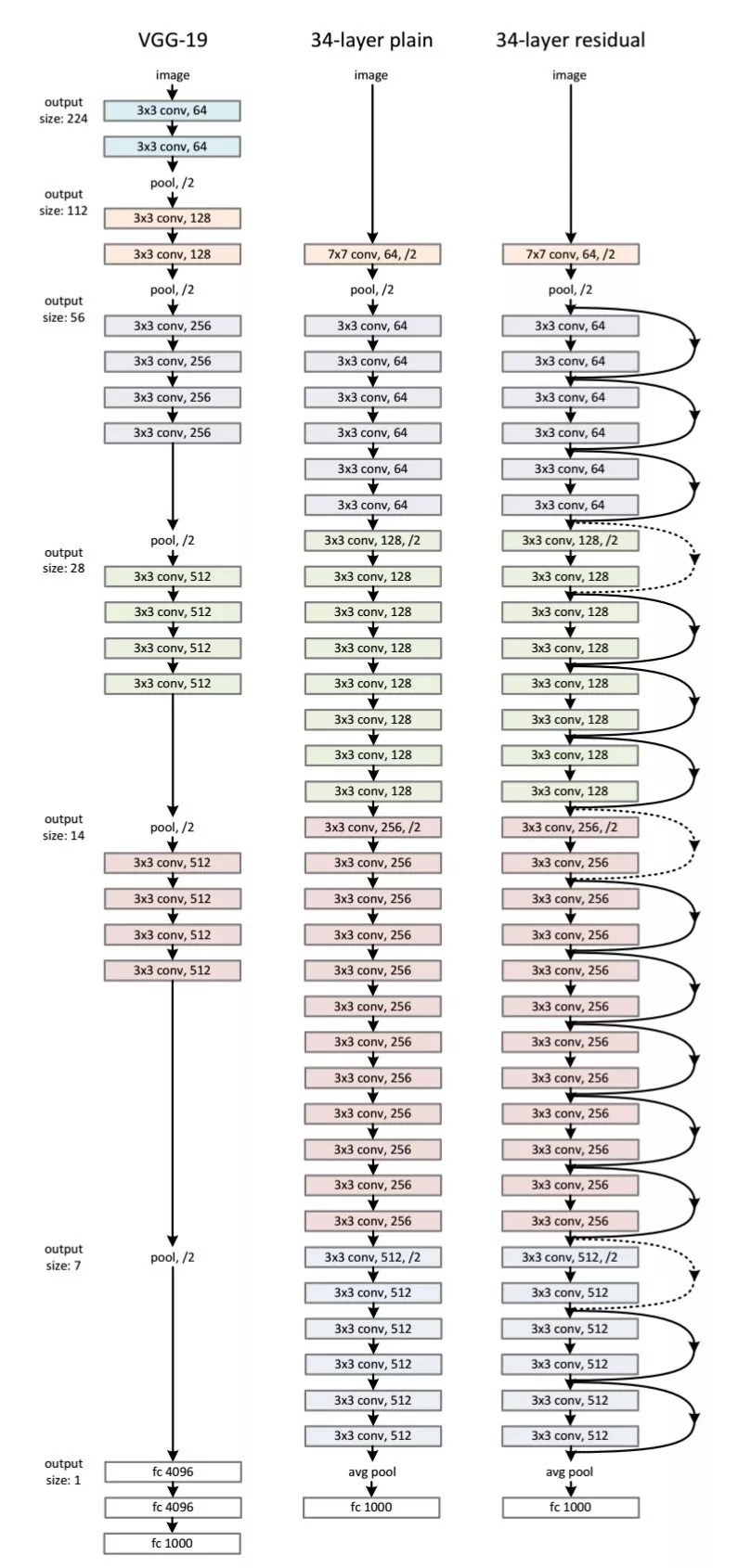

看完google net,就轮到resnet了。resnet有两个基础版本,今天我们来看看resnet v1。Resnet v1是何恺明等人在2015年提出的CNN结构,其研究重点在于极深神经网络的梯度消失问题。

梯度消失

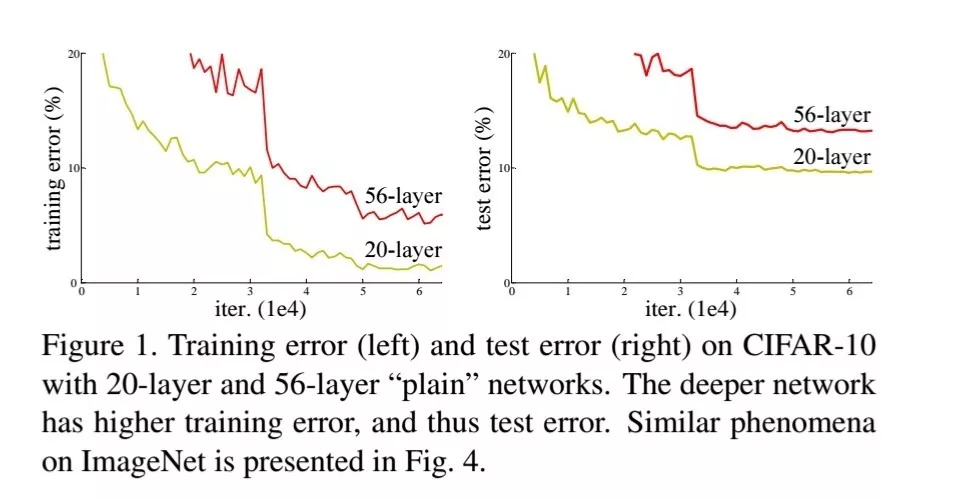

梯度消失是自深度神经网络问世以来就一直存在的问题。梯度是神经网络学习新知识的主要动力来源,梯度消失是指梯度值趋近于0。神经网络之所以能计算出梯度是由于它能从数据中过滤出特征,并得到最终误差,这个过程犹如人类从错误与失败中学习经验。深度越深说明这个学习路线越长,会经过多层过滤,结果就是在一定阶段开始什么也学习不到了(几乎全部被滤掉了)。

旁路机制

梯度消失问题在迭代训练中会导致网络难以收敛甚至停止收敛,本文使用一种旁路机制,让你无需多考虑网络每层的参数设计,并且可以在很大程度上避免梯度消失问题。至此,CNN网络就可以被无忧无虑地加深到过百层。

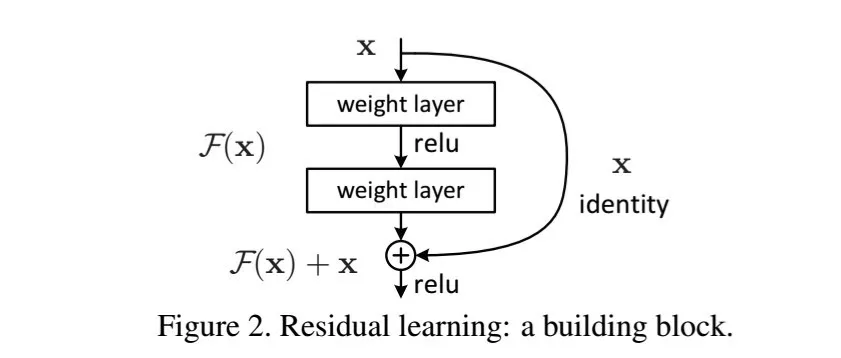

旁路设计的精髓在于一旦在前传过程中检测到学习能力消失时,就原封不动的向下一层传递原始数据而不再过滤。这样,关键信息在传递到深层时仍然存在。这种旁路与检测机制都是由基本算法完成的,非常简洁与快速,而要保障旁路传递完整信息,则需要使用恒等映射作为激活函数。

恒等映射

恒等映射就是y=x,是不是感觉到一种返璞归真的清凉?谁说小学数学没有用。这一简单的设计为之后的CNN网络打开了设计的大门,我们后文会继续讨论它

写完本文时,一种称为GNN的图模型正开始浮出水面,未来是否神经网络会有自己的设计图,甚至出现无限深度的神经网络,这一切都值得我们思考。

(End.)

2018年12月28日 10:39

ꄘ浏览量:0